Opiniones

Cómo comparar herramientas de seguridad de aplicaciones: guía para la toma de decisiones

Escritor y editor

Actualizado

7 min

Desde hace un tiempo, en nuestras conversaciones con empresas de diversos sectores, hemos identificado lo difícil que resulta decidir qué solución de seguridad de aplicaciones utilizar. La información que suele estar a tu disposición no es suficiente; después de revisar los sitios web de los proveedores, los informes de analistas con sus cuadrantes o las demos de ventas, diseñadas para mostrar solo el mejor escenario posible, no es fácil saber cómo va a funcionar realmente una herramienta con tu código, en tus pipelines, con tus desarrolladores, etc. Pensamos que lo adecuado es ofrecerte un proceso estructurado y basado en evidencia para comparar soluciones en las dimensiones más relevantes: efectividad de detección, compatibilidad operativa, adopción por parte de los desarrolladores e impacto en el negocio.

Esta guía se basa en nuestra experiencia como empresa de AppSec que ha probado herramientas —las propias y las de terceros— contra aplicaciones reales, midiendo qué detectan, qué omiten y cuánto cuesta actuar sobre lo que reportan. Una conclusión a la que llegamos de forma constante es que ninguna herramienta automatizada por sí sola ofrece una imagen completa de la exposición al riesgo de una aplicación. El enfoque híbrido, que combina escaneo automatizado con pentesting experto gestionados desde una misma plataforma, proporciona la precisión de detección y la claridad operativa que las organizaciones realmente necesitan. Nuestro benchmark de 36 herramientas de terceros lo confirmó: el escáner con mejor rendimiento detectó el 22,7% de las vulnerabilidades, mientras que nuestros pentesters identificaron el 89,6%.

Ya sea que estés preparando una decisión de compra, asesorando una evaluación técnica o analizando ofertas competitivas, el marco que presentamos a continuación te ayudará a comparar soluciones de AppSec con rigor y confianza.

1. Comienza por el propósito de la comparación

Antes de abrir un solo dashboard, aclara qué intentas lograr. El propósito del benchmark determina qué criterios tienen mayor peso.

Si eres un comprador evaluando proveedores, priorizarás la exactitud de detección, la facilidad de integración y el costo total de propiedad.

Si eres un líder de seguridad que evalúa su conjunto de herramientas actual, el recall y la tasa de falsos negativos se vuelven fundamentales, ya que lo que realmente te estás preguntando es "¿qué estamos dejando pasar?".

Si la comparación alimenta un análisis de go-to-market, el posicionamiento competitivo y la diferenciación son lo más importante.

Si el benchmark respalda una evaluación de M&A o partnership, la escalabilidad y la compatibilidad con la arquitectura serán las protagonistas.

Define este objetivo de manera explícita y documenta tu decisión. Será el ancla de todas las que vengan después.

2. Delimita el alcance técnico

"Seguridad de aplicaciones" es un concepto demasiado amplio para funcionar como categoría de benchmark. Es necesario especificar qué métodos de prueba y contextos se van a comparar:

SAST (análisis estático de código fuente)

DAST (pruebas dinámicas de aplicaciones en ejecución)

SCA (análisis de composición de software para dependencias de terceros)

IAST / RASP (instrumentación y protección en tiempo de ejecución)

Pentesting (evaluación de seguridad manual y experta)

ASM / CAASM (gestión de la superficie de ataque)

Seguridad cloud, de APIs o de infraestructura

Además, debes considerar el stack tecnológico y la forma de implementación preferida. Un benchmark bien delimitado podría formularse así: "Comparación de SAST y SCA para pipelines de CI/CD con repositorios backend en Java y Node.js". Este nivel de especificidad evita comparaciones desiguales y mantiene la evaluación centrada en tu entorno real.

3. Construye un entorno de prueba controlado

Recuerda que las demos guiadas por el proveedor están diseñadas para mostrar fortalezas, no para revelar vacíos. Es necesario probar las soluciones en un entorno que tú controles.

Selecciona aplicaciones realistas: Lo ideal es utilizar dos o tres aplicaciones reales de distintos stacks tecnológicos: por ejemplo, un servicio backend en Java o Node.js, un frontend SPA y una API. Incluye tanto CVE conocidos en dependencias como fallas originales a nivel de aplicación, ya que las herramientas que funcionan bien con vulnerabilidades catalogadas suelen tener dificultades con las de lógica de negocio.

Estandariza las condiciones: Cada herramienta evaluada debe escanear el mismo commit, con la misma configuración de pipeline, la misma ventana de ejecución y políticas configuradas de la manera más equivalente posible. Sin condiciones controladas, lo que terminas midiendo son diferencias de configuración, no capacidad de detección.

4. Mide las métricas técnicas clave

4.1. Exactitud

Medir la exactitud exige monitorear tres valores en cada herramienta:

Verdaderos positivos (TP): vulnerabilidades reales correctamente identificadas

Falsos positivos (FP): elementos que no son vulnerabilidades pero que se señalan como tales

Falsos negativos (FN): vulnerabilidades reales que la herramienta no detectó

A partir de estos valores se derivan dos métricas esenciales. La precisión (TP / [TP + FP]) indica qué proporción del resultado es realmente accionable. El recall (TP / [TP + FN]) indica qué proporción del riesgo real está siendo detectada.

Es fundamental prestar atención a ambas. Una herramienta que reporta muy pocos falsos positivos parece eficiente, pero si logra esa baja tasa de FP porque también omite una gran parte de las vulnerabilidades reales, está ofreciendo una visión incompleta del riesgo que resulta peligrosa. En nuestro estudio de benchmark, el escáner automatizado con mayor número de verdaderos positivos aun así omitió casi el 80 % del universo de vulnerabilidades. El recall, en particular para vulnerabilidades de severidad alta y crítica, es la métrica que separa una seguridad aceptable de una protección genuina.

4.2. Calidad de los hallazgos

Un recuento de total de detecciones no es suficiente. Para cada hallazgo, evalúa lo siguiente:

Explotabilidad: ¿Se trata de una debilidad teórica o de una vulnerabilidad explotable en la práctica?

Evidencia: ¿El hallazgo incluye una prueba de concepto o una ruta de explotación clara? Los hallazgos sin evidencia generan sobrecarga de triaje y acaban con la confianza del desarrollador.

Contexto de negocio: ¿El reporte ayuda a entender el impacto real de la vulnerabilidad sobre la aplicación y los datos específicos de la organización?

Exactitud en la priorización: ¿La severidad asignada (CVSS o equivalente) es realista o se necesita otra métrica? Métricas basadas en riesgo, como nuestro CVSSF, y un conjunto de factores como alcanzabilidad, costo de remediación y estatus en KEV, ayudan a las organizaciones a ir más allá de los meros valores de severidad hacia una imagen más precisa de la exposición al riesgo agregada.

4.3. Rendimiento

Mide la huella operativa de cada herramienta:

Duración del análisis: Tiempo total desde la ejecución hasta la entrega de resultados

Impacto en CI/CD: ¿El escaneo bloquea el pipeline? Si es así, ¿por cuánto tiempo? ¿Puede ejecutarse de forma incremental o requiere un análisis completo cada vez?

Consumo de recursos: CPU, memoria y carga de red durante la ejecución, particularmente importante a escala

Evalúa la experiencia del desarrollador

Una herramienta que los desarrolladores evitan o en la que desconfían genera menos remediación, tiempos de corrección más largos y menor adopción, sin importar cuán precisa sea su detección.

Haga que un desarrollador real de su equipo evalúe cada herramienta en los siguientes aspectos:

Fricción en el onboarding: ¿Cuánto tiempo le toma a un desarrollador pasar del primer acceso a comprender y actuar sobre un hallazgo?

Claridad de los hallazgos: ¿Los hallazgos están escritos en un lenguaje que los desarrolladores entienden, con suficiente contexto para reproducir y corregir el problema?

Guía de remediación: ¿La herramienta proporciona sugerencias específicas a nivel de código o solo descripciones genéricas de CWE?

Profundidad de integración: ¿Funciona dentro de los entornos que sus desarrolladores ya utilizan, como GitHub, GitLab o Jira? ¿Muestra los hallazgos en los pull requests?

Eficiencia del flujo de trabajo: ¿Cuántos pasos se necesitan para pasar de una vulnerabilidad reportada a un issue cerrado? La implementación de IA y la reducción de clics y cambios de contexto implican una remediación más rápida

6. Evalúa la capacidad operativa

Las pruebas de seguridad no se tratan solo de hallazgos, sino además de que la solución pueda operar de forma confiable a la escala de tu organización y dentro de sus requisitos de gobernanza. Así que asegúrate de considerar lo siguiente:

Escalabilidad: Prueba el comportamiento a medida que aumenta el volumen. Supongamos que una herramienta funciona bien con 10 repositorios. ¿Sigue rindiendo igual con 100, con 1.000? Evalúa el soporte multi-tenant, el rendimiento bajo escaneos concurrentes y los rate limits de la API.

Gobernanza y gestión. Observa cómo la solución maneja las políticas de seguridad, los flujos de excepciones, el seguimiento de SLA sobre hallazgos abiertos y las estrategias de retesteo. ¿Puede ejecutar escaneos inteligentes e incrementales o cada cambio dispara un análisis completo? ¿Permite definir políticas para romper el build que bloqueen el despliegue cuando existan vulnerabilidades no aceptadas? Nuestros datos muestran que las organizaciones que rompen el build remedian vulnerabilidades un 50% más rápido que las que no lo hacen.

7. Cuantifica el valor de negocio

Para los tomadores de decisiones ejecutivos, el benchmark debe traducirse en términos de negocio:

Costo total de propiedad (TCO): Incluye las tarifas de licenciamiento, los costos de infraestructura y el esfuerzo humano necesario para operar y triar los resultados de la herramienta. Una herramienta más barata que genera una carga pesada de triaje puede resultar más costosa en la práctica que una solución más cara pero más precisa.

Reducción del riesgo: Haz seguimiento de las vulnerabilidades de severidad crítica y alta cerradas por mes y del tiempo medio de remediación (MTTR). Estas son las métricas que conectan la inversión en AppSec con una mejora medible de la seguridad.

Adopción por parte de los desarrolladores: Mide cuántos equipos de desarrollo utilizan activamente la herramienta y cómo afecta su flujo de trabajo. Es preferible una solución que rompa los silos de datos, ya que estos mantendrán bajas las tasas de remediación.

8. Utilice un scorecard ponderado

Una vez que hayas recopilado datos en todas las dimensiones, estructura su comparación con un scorecard ponderado. Asigna pesos según el objetivo que definiste en el paso 1 y puntúa cada solución de forma consistente.

Un ejemplo simplificado:

Categoría | Peso | Solución A | Solución B |

|---|---|---|---|

Precisión de detección (recall) | 30% | 8 | 6 |

Tasa de falsos positivos | 15% | 7 | 9 |

Experiencia del desarrollador | 20% | 6 | 8 |

Integración con CI/CD | 15% | 9 | 6 |

Capacidad operativa | 10% | 8 | 7 |

TCO | 10% | 6 | 8 |

Total ponderado | 100% | 7,4 | 7,2 |

Los pesos y categorías específicos deberían reflejar las prioridades de tu organización. Lo importante es que la puntuación sea explícita y defendible.

9. Documenta todo con evidencia

Cada afirmación en tu comparativo debe ser rastreable. Recopila capturas de pantalla de los hallazgos, logs de los escaneos, reportes de vulnerabilidades exportados y los commits específicos donde se validó cada verdadero positivo y cada falso positivo. Esta base de evidencia elimina disputas subjetivas y hace reproducible la evaluación, lo cual resulta útil tanto para la toma de decisiones interna como para revisitar la comparación cuando las herramientas lancen nuevas versiones.

10. Evita errores comunes

Varios patrones suelen desmejorar los benchmarks de AppSec:

Comparar listas de features en lugar de resultados: La página de features de un proveedor indica lo que una herramienta o servicio dice hacer, no lo que realmente hace con tus aplicaciones; céntrate en resultados medidos.

Usar solo aplicaciones de prueba estándar: Las aplicaciones intencionalmente vulnerables son un buen punto de partida, pero no representan la complejidad de las bases de código reales. Incluye aplicaciones con lógica de negocio personalizada y arquitectura realista.

Dar demasiada importancia a las demos guiadas: Una demo controlada por el proveedor está optimizada para mostrar el producto en su mejor versión. Insiste en probar tus propias aplicaciones en un entorno que tú administres.

Ignorar los falsos negativos: Una herramienta que reporta menos hallazgos no es necesariamente más precisa, ya que podría estar omitiendo vulnerabilidades reales. Sin medir el recall, no es posible distinguir una herramienta o solución precisa de una que simplemente no está viendo lo suficiente.

Excluir a los desarrolladores de la evaluación: Si las personas que van a remediar las vulnerabilidades no participan en la evaluación de las herramientas, se corre el riesgo de elegir una solución que falle operativamente.

Por qué conviene un enfoque híbrido todo en uno

Un benchmark realizado con este nivel de rigor tiende a revelar un patrón consistente: ninguna herramienta automatizada por sí sola cubre todo el espectro de riesgos de una aplicación, ni siquiera con los avances recientes de la IA (p. ej., AI SAST). Los escáneres automatizados destacan en velocidad, consistencia y cobertura de patrones de vulnerabilidades conocidos, pero sistemáticamente omiten problemas complejos, de lógica y dependientes del contexto, que constituyen los riesgos más severos. Nuestros datos muestran que se requiere de expertos humanos para detectar casi el 99% de las vulnerabilidades de severidad crítica.

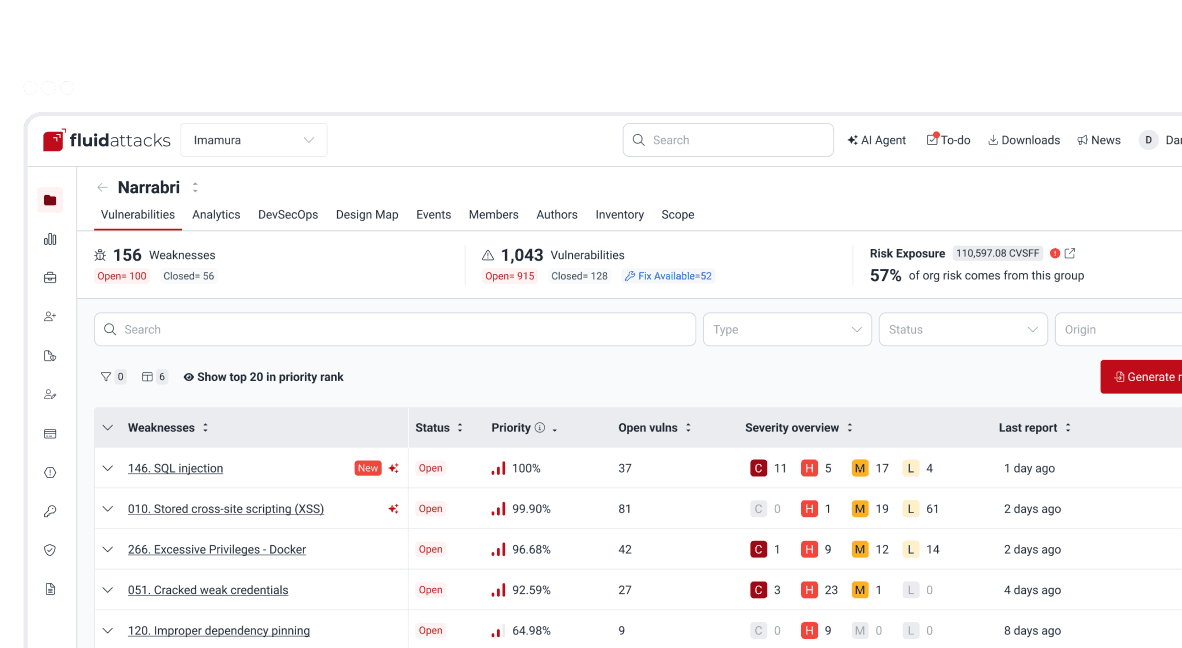

Por eso defendemos —y hemos construido nuestra solución Hacking Continuo en torno a— un modelo híbrido que integra herramientas automatizadas potenciadas por IA con pentesting experto en una sola plataforma. Cuando ambos métodos operan de forma continua a lo largo del SDLC y sus hallazgos fluyen hacia una vista de gestión unificada, disponible para los equipos de Dev y de Sec, las organizaciones obtienen la profundidad de detección, la exactitud en la priorización y la velocidad de remediación que necesitan para reducir el riesgo de verdad. El framework para comparaciones ofrecido por esta guía te permitirá verificar esa afirmación por tu cuenta, con tus propias aplicaciones y en tus propios términos.

Empieza ya con la solución de seguridad de aplicaciones de Fluid Attacks

Suscríbete a nuestro boletín

Mantente al día sobre nuestros próximos eventos y los últimos blog posts, advisories y otros recursos interesantes.

Otros posts